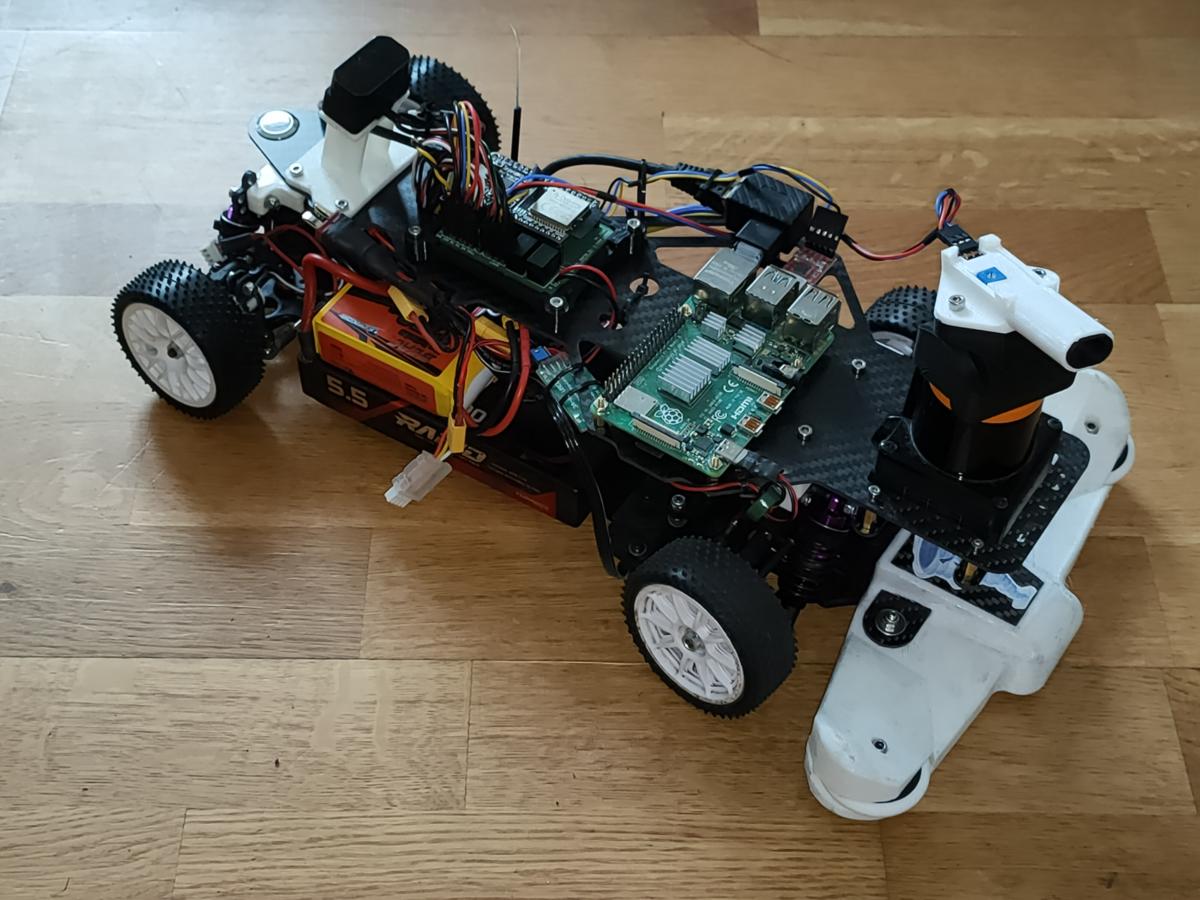

Voici quelques informations au sujet de la voiture "Blizzard" qui a participée à la Tiny TRR 2023 dans les catégories Roulant et DLVV. Elle a obtenu les meilleurs chronos dans les deux épreuves.

Ce robot est une évolution à la fois de :

- la mini-traction rouge de l'année 2022 (voir https://www.robot-ma...-tiny-trr-2022/),

- le "Phoenix" de cette année (voir https://www.robot-ma...-2023/?p=118676).

Avant la course :

Pendant la course :

Apres la course :

***

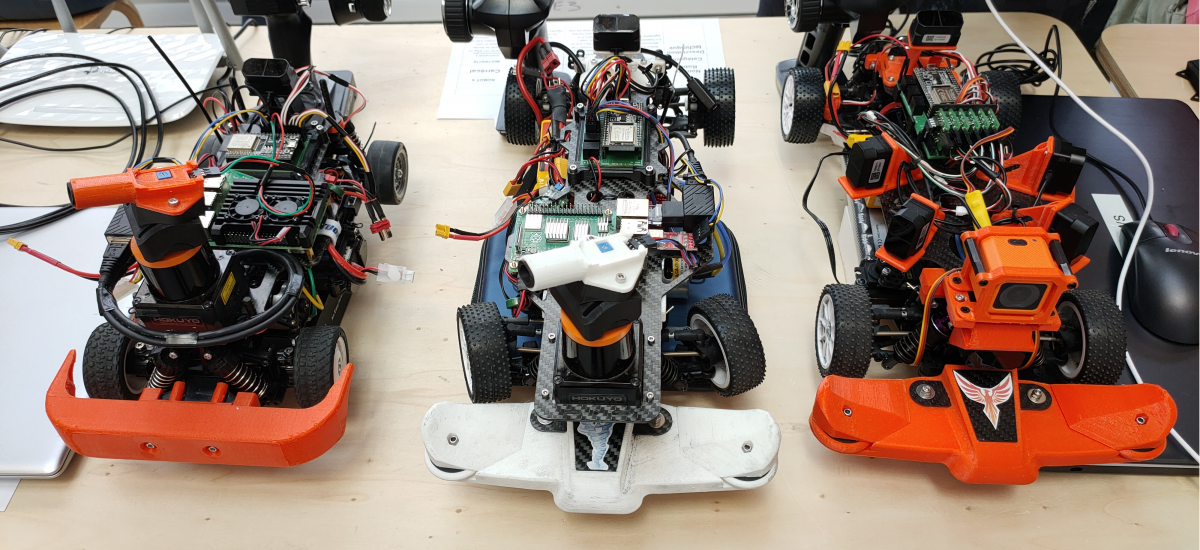

Ce robot trouve son inspiration dans les courses internationales de F1teenth, sur de grands circuits, avec des roulants de grande taille, bardés de capteurs (LIDAR, caméra stéréo, etc),.

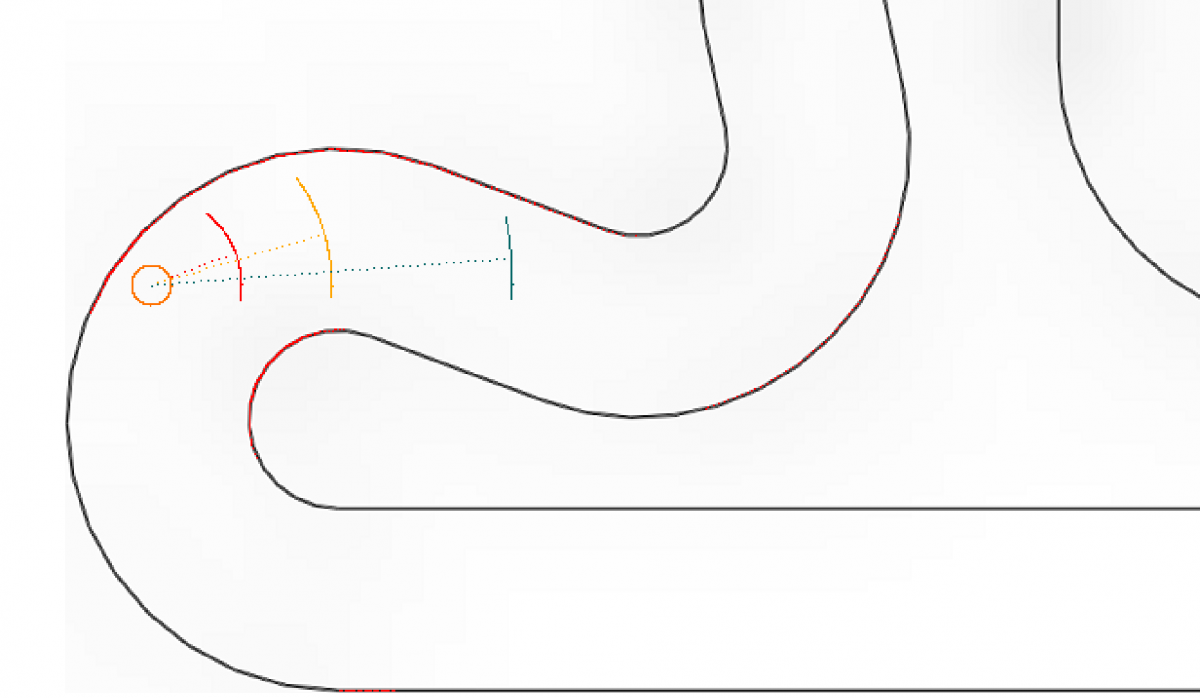

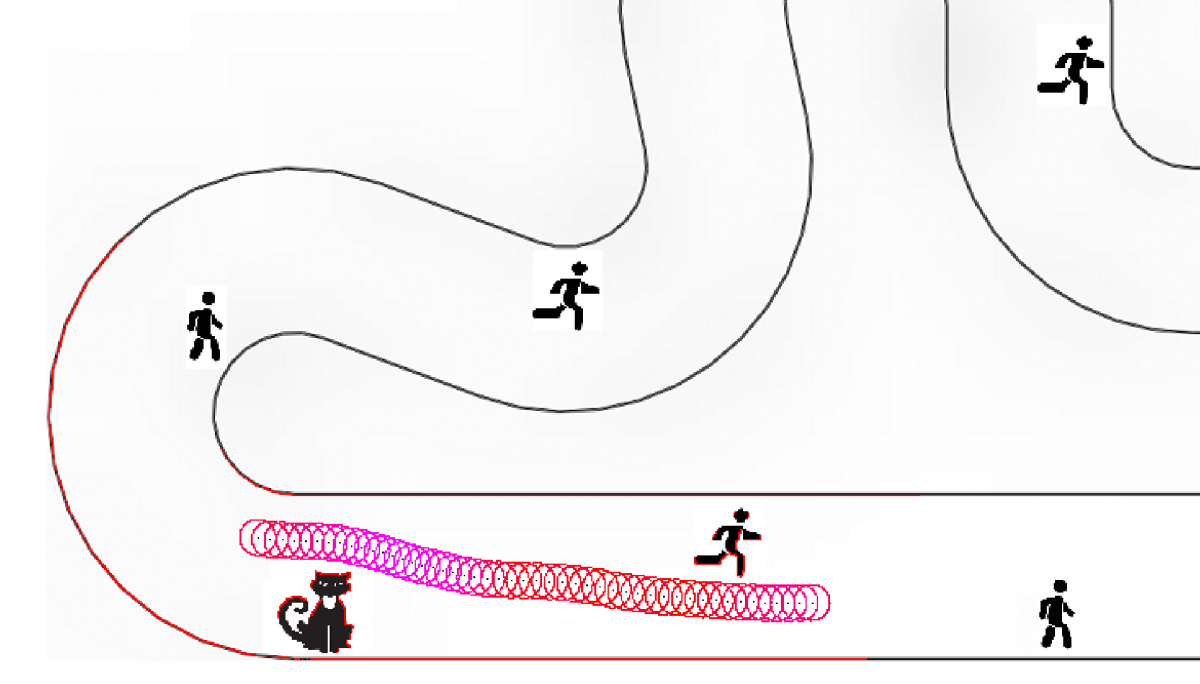

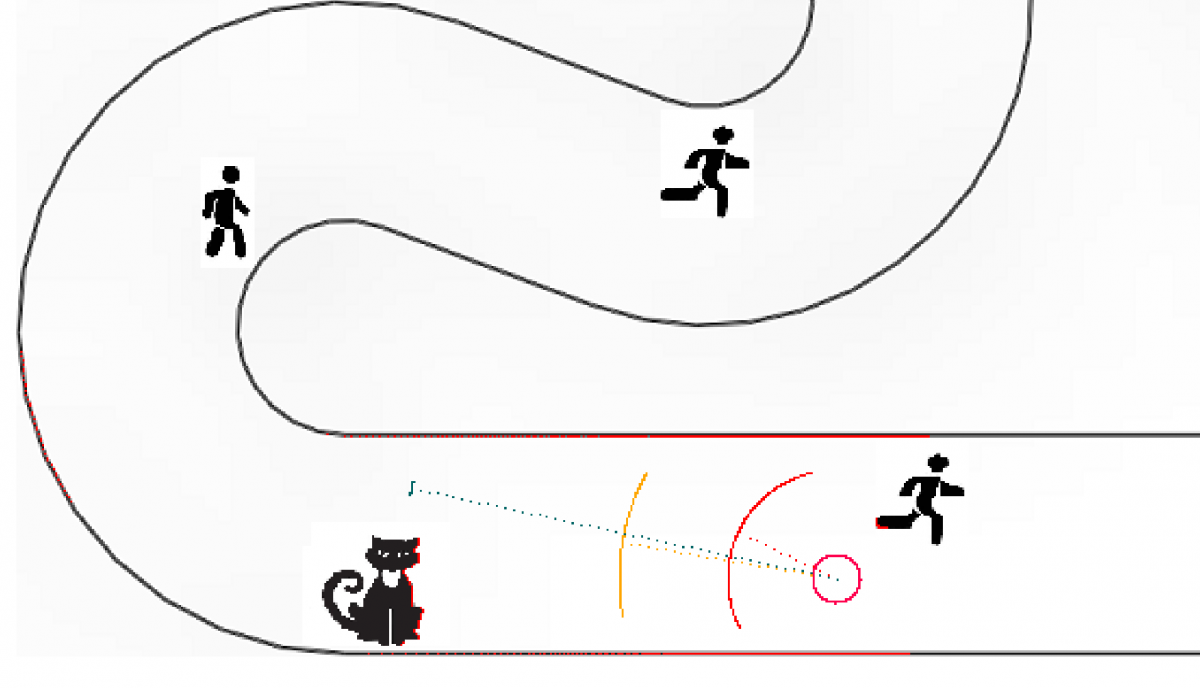

Certains de ces robots mettent en œuvre des algorithmes de navigation qui dérivent de VFHou encore Follow the Gap..

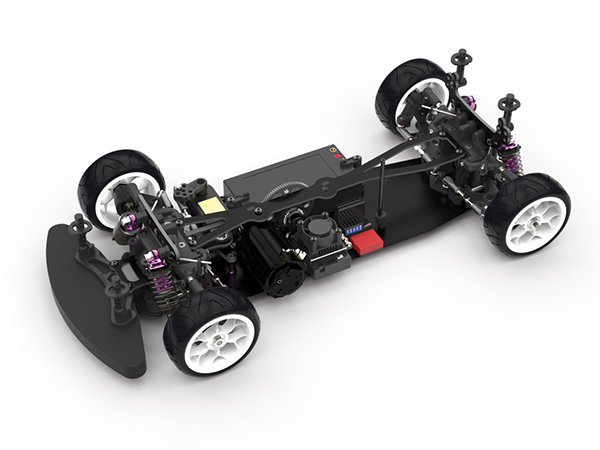

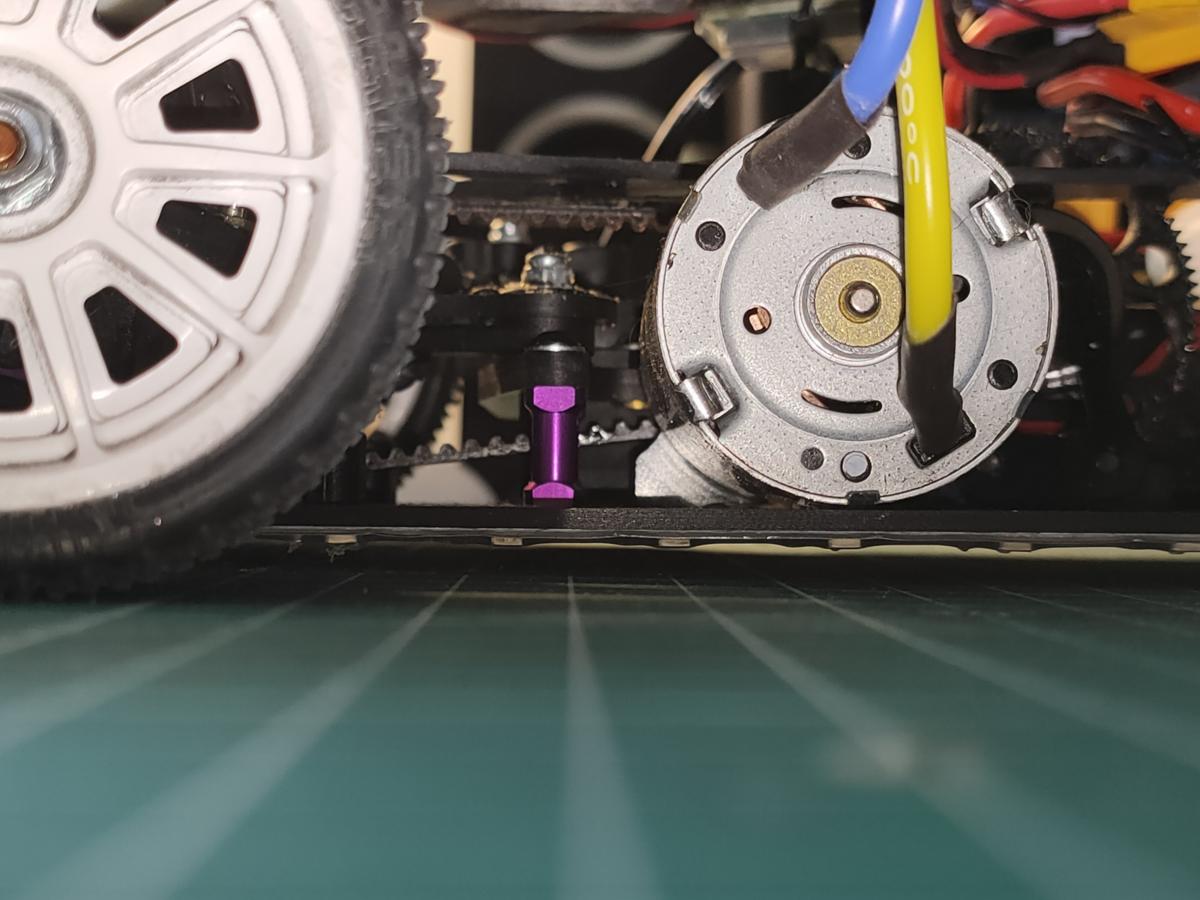

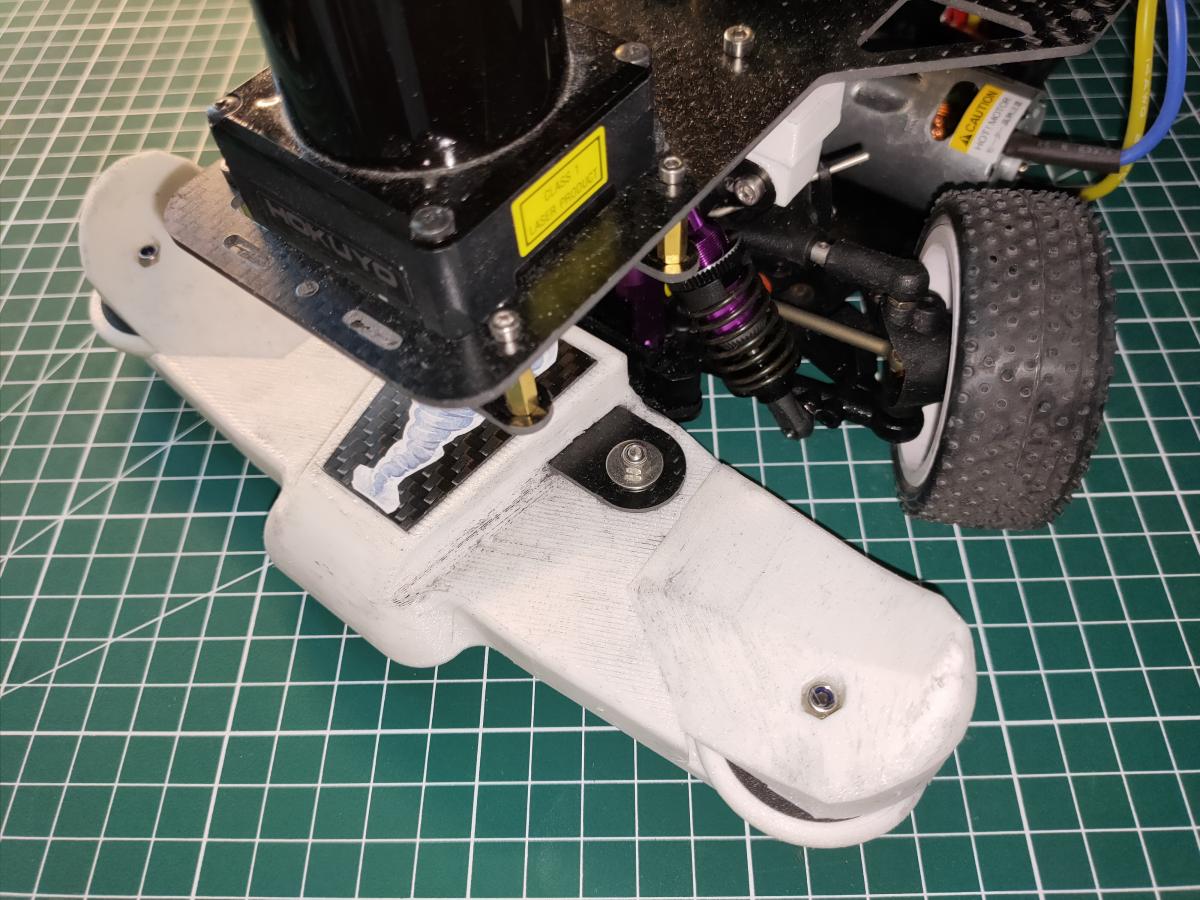

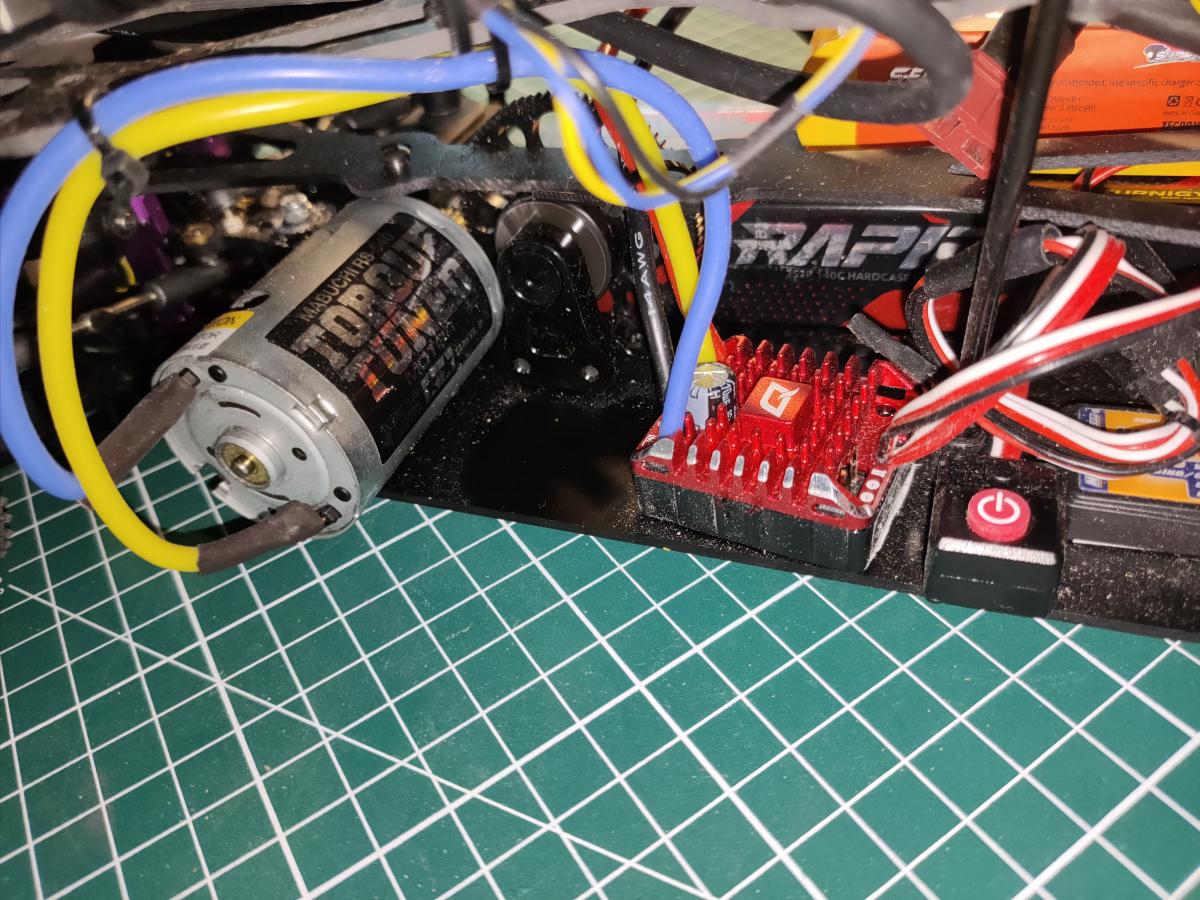

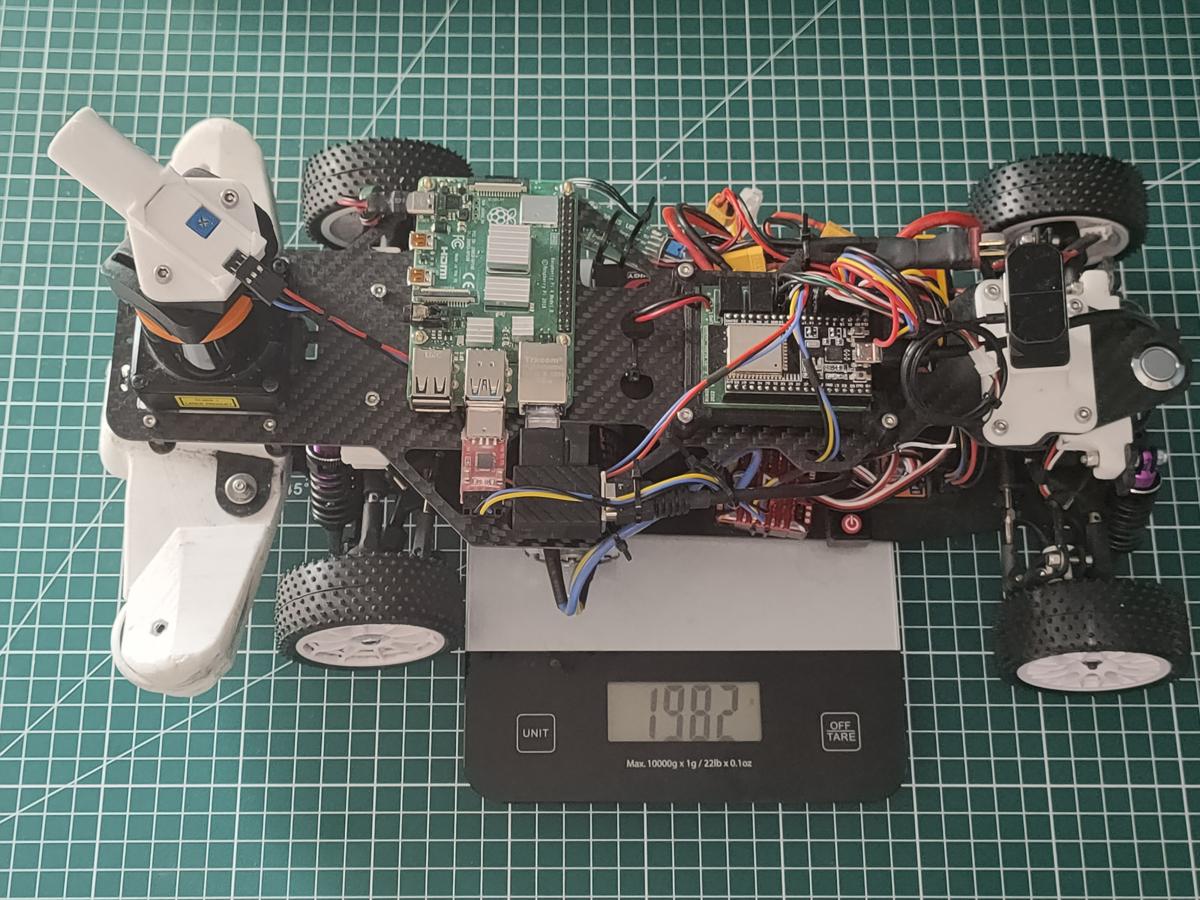

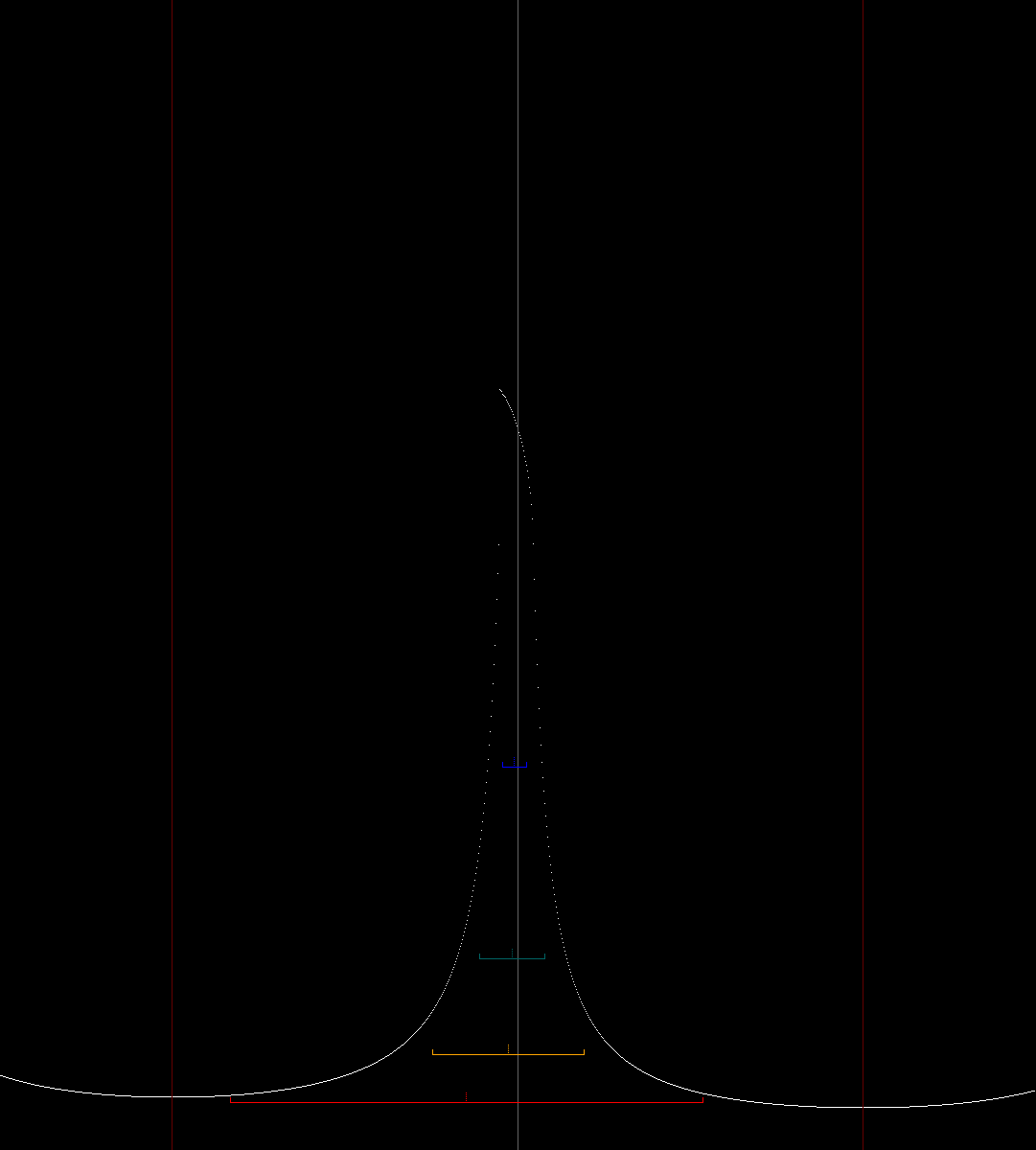

A quelques semaines de la Tiny TRR, mon premier robot "Phoenix" était prêt pour la course. Je me suis lancé dans la réalisation d'un second robot "Blizzard", permettant d'évaluer le potentiel des solutions techniques adoptées en F1theenth. En faisant courir deux robots, similaires sur le plan mécanique (même châssis, même motorisation, mêmes réglages, masse proche) mais embarquant des capteurs et des algorithmes différents, j'allai pouvoir évaluer et comparer objectivement ces différentes solutions.

Sincèrement, je n'étais pas convaincu par les solutions F1theenth. Le robot doit embarquer une Rpi ou une Jetson, avec son systeme alimentation (5v et 12 ou 24v), et un capteur plutôt lourd et fragile et très lent.

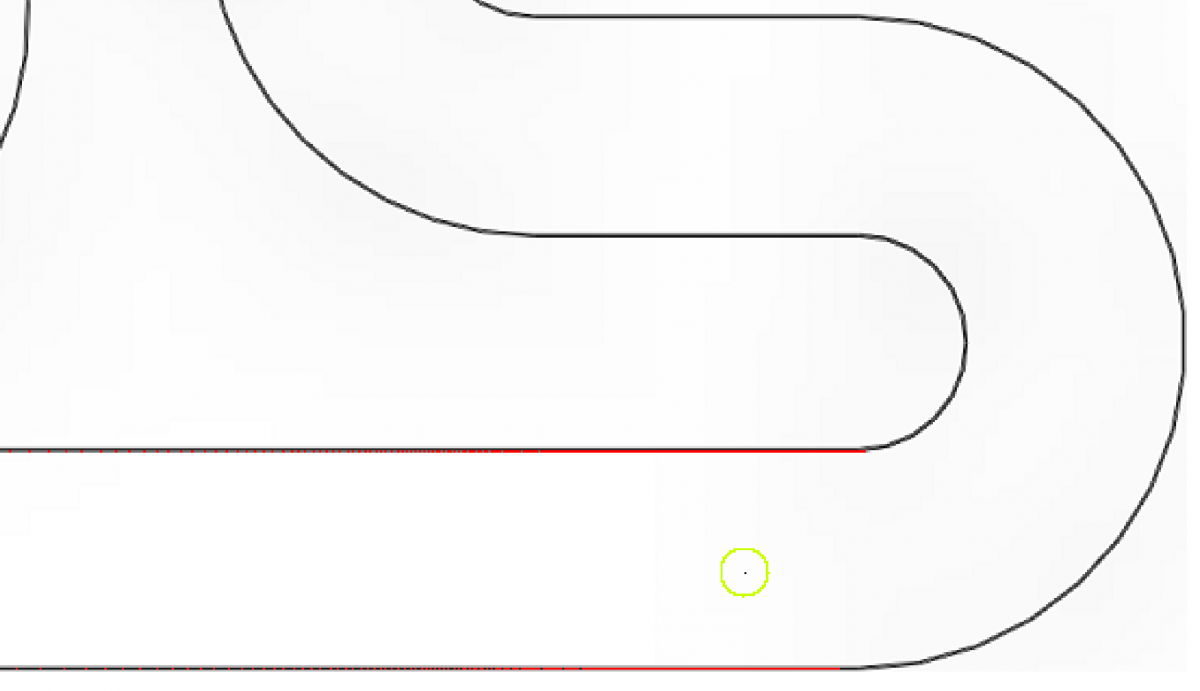

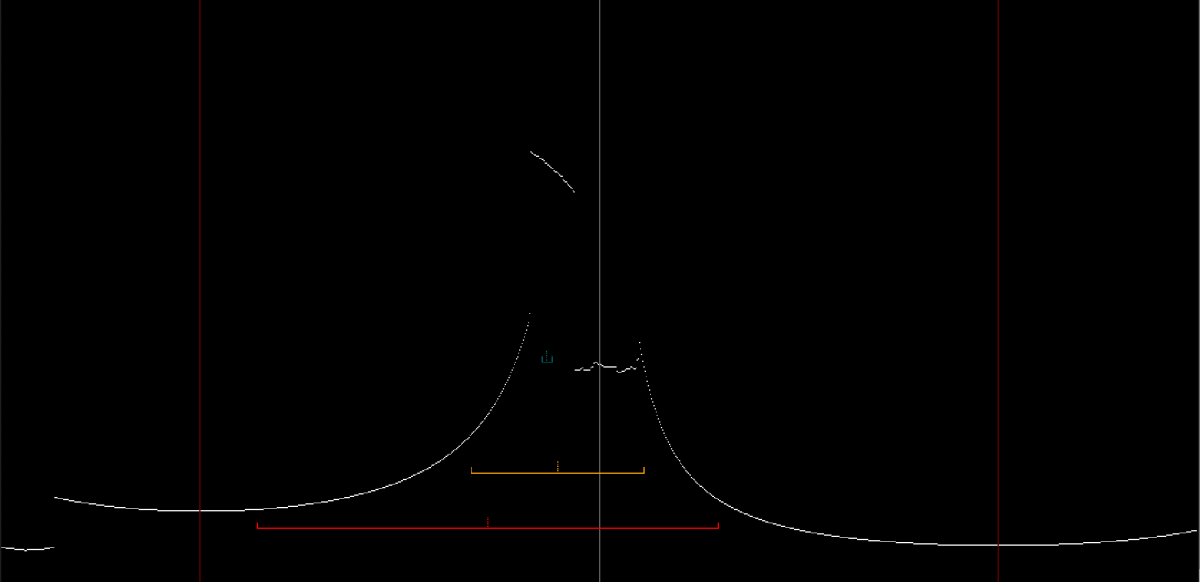

Le "Phoenix" avec plusieurs télémètres TF Mini Plus permettant jusqu'à 1000 mesures par seconde, et un algorithme "maison" cadencé à 333Hz environ tournant sur Arduino (= fréquence PWM du servo de direction), la réactivité de l'asservissement est excellente et largement supérieure à ce qui est possible d'implémenter dans une F1teenth, à cause de la limite de vitesse de rotation d'un LIDAR (typiquement de 10Hz à 40Hz selon le modèle) et des caméra (30 à 60fps). Et je ne parle même pas du temps de traitement de toutes ces données et de la latence que cela induit. A la vitesse de 4m/s, un délai d'acquisition et de traitement de l'ordre de 50 ms correspond à une distance parcourue de 20cm lorsque le robot est à pleine vitesse dans la ligne droite de la Tiny TRR (et ne parlons pas de la TRR normale, là ca ferait 50 cm). Ca signifie une consigne de direction et de gaz tous les 20 cm... les bordures sont toujours à moins de 50 cm du robot... je n'y croyais pas du tout.

Bon, j'ai changé d'avis après cette édition de la Tiny TRR ! Je comprends mieux à quel point nous (Carré92) avions du retard technologique par rapport au champion de 2019 de la dernière (maxi) TRR.. Non seulement, "Blizzard" équipé d'un LIDAR prend une seconde au tour sur "Phoenix" (même moteur, même châssis, mêmes réglages...), mais surtout il réalise la DLVV avec rigoureusement le même algorithme et les mêmes réglages, à l'exception d'une légère diminution de la vitesse maximale (75%).

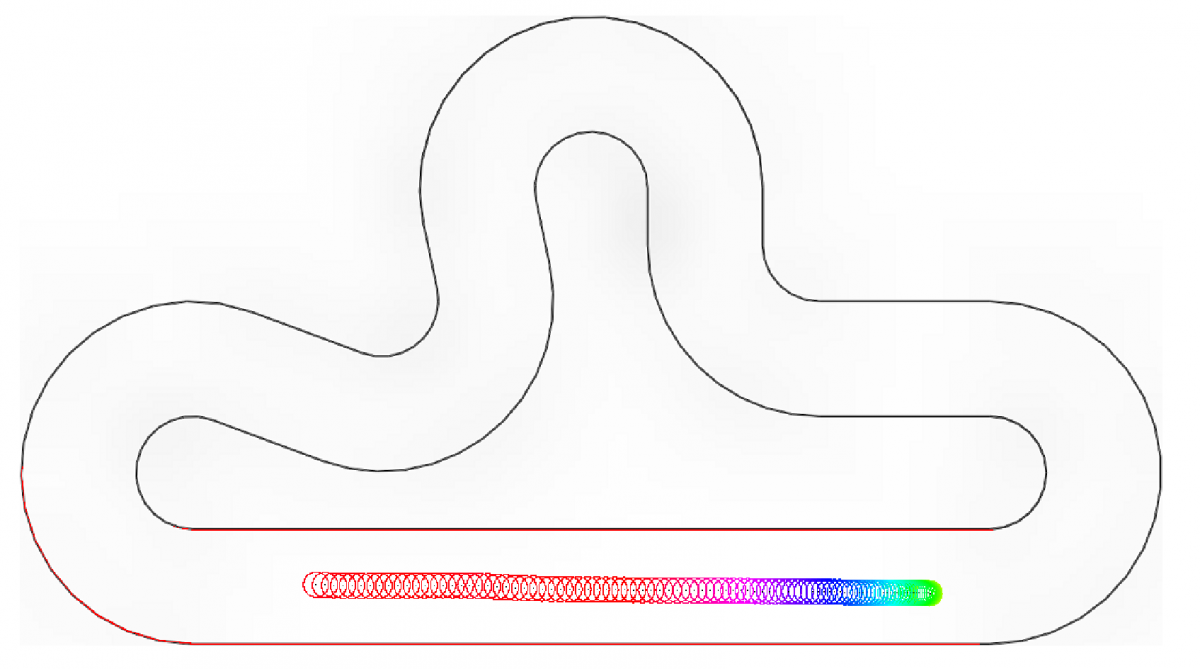

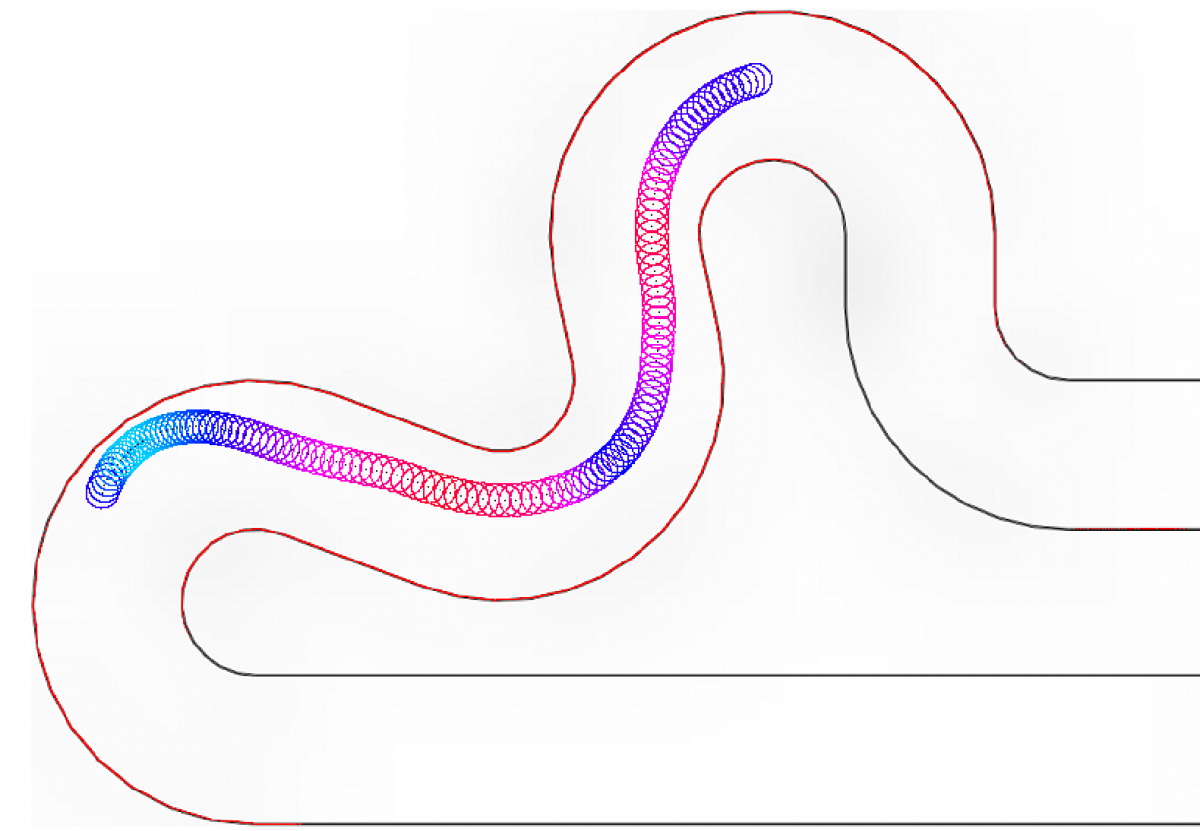

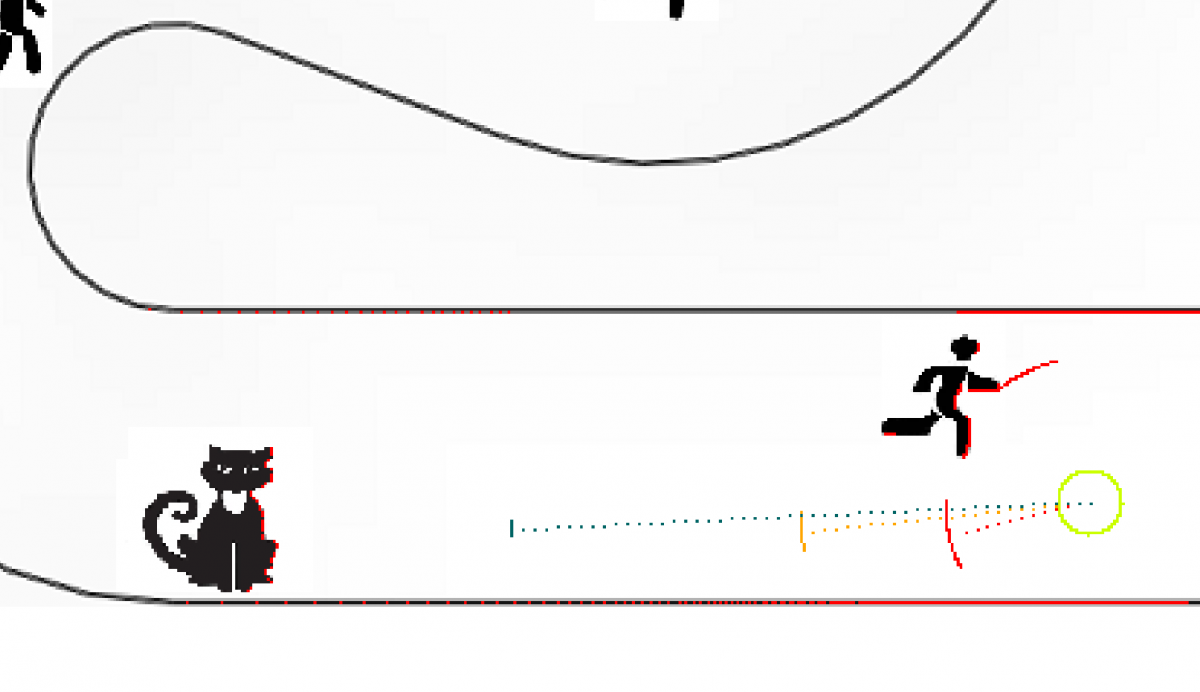

Course 'roulant" :

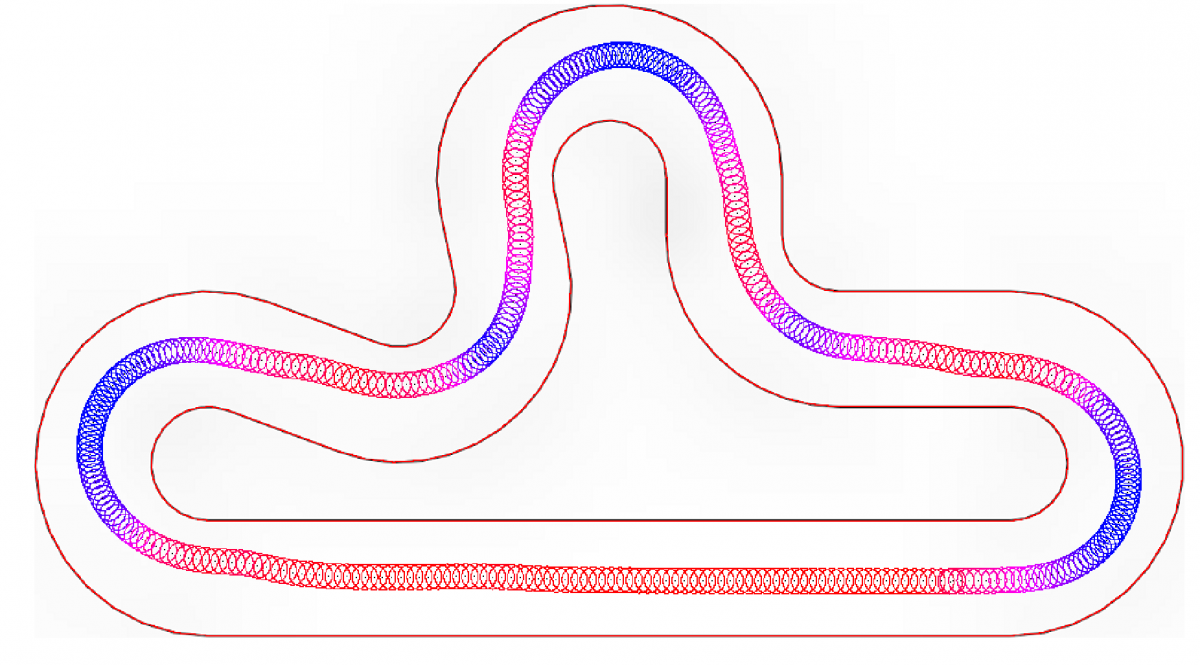

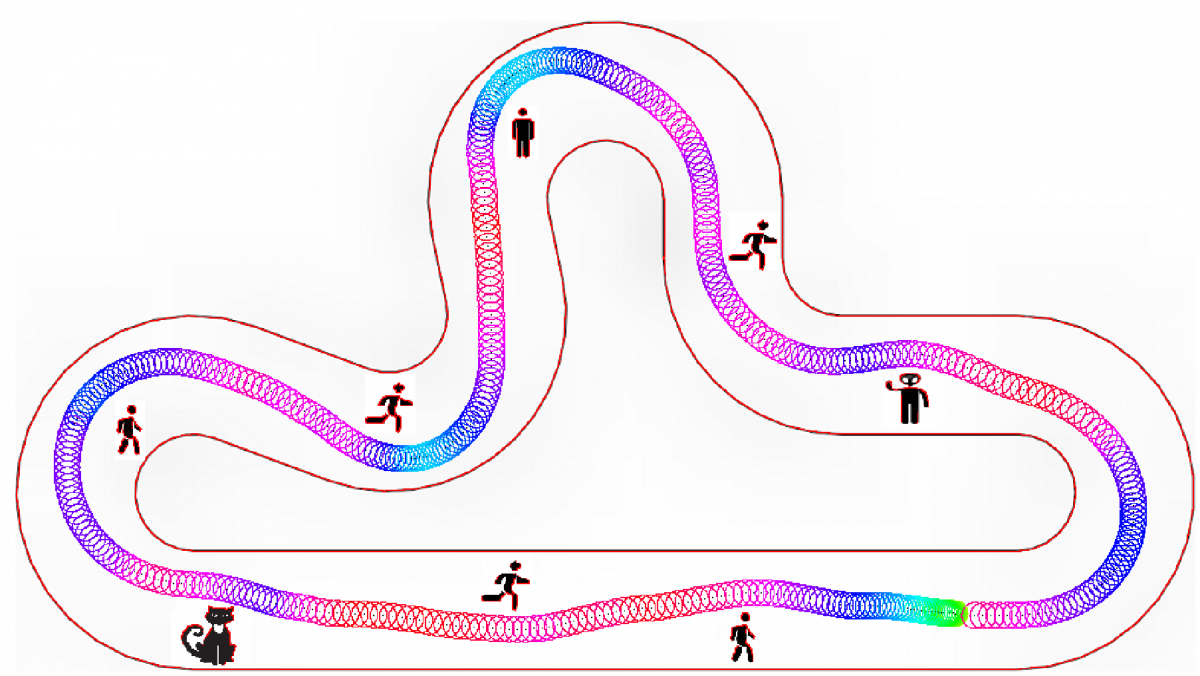

Course "DLVV":

A suivre !