non ... je parle bien du machine learning sur base de réseau neurone (y'a une publi sur Stanford à ce sujet). Par exemple si tu fais du ML sur Tensorflow (et je ne te parle pas de ML à la sauce random forest) bah tu fais pas de l'IA ... Pas encore. On devrait trouver un autre mot pour cela.... D'ou mon opposition à l'utilisation du mot IA ... A ce sujet j'ai écrit un blog http://www.jfortias.net/2018/01/lia-nest-pas-intelligente.html

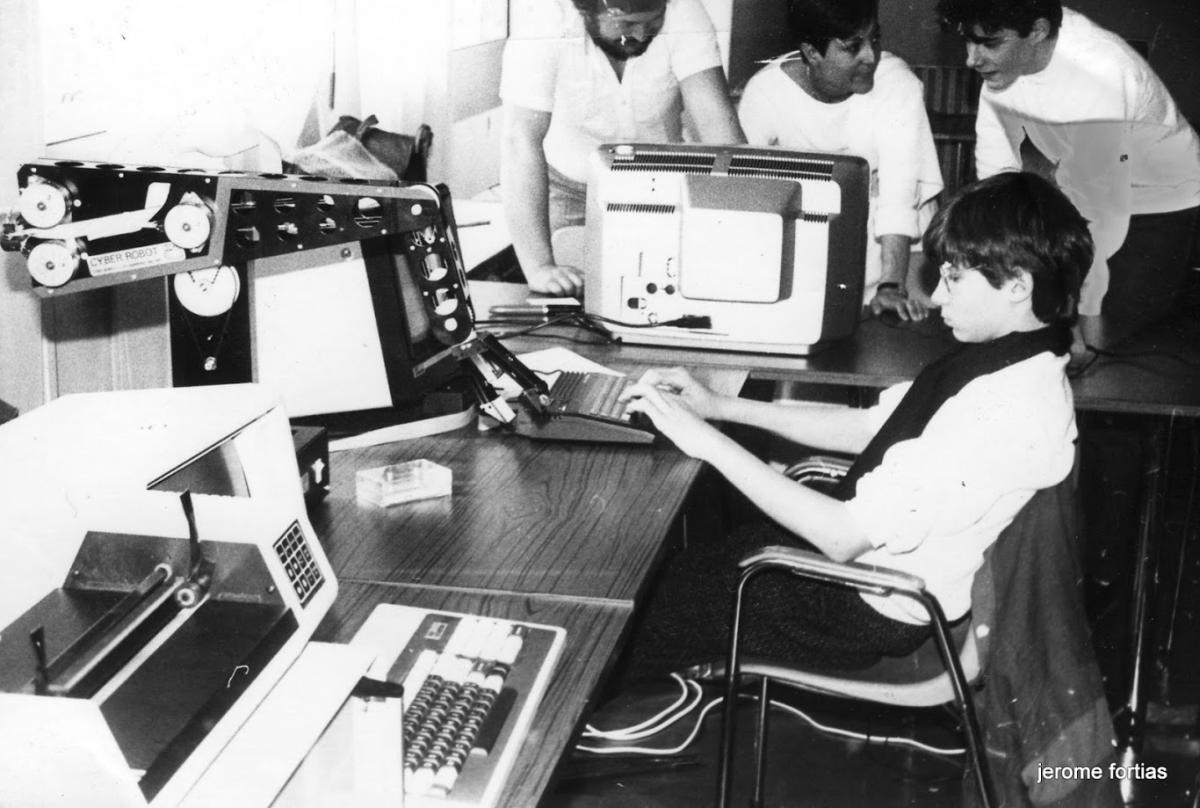

Les réseaux neurones sont trés anciens. j'avais par exemple créer des trucs sur la base d'un livre "Fuzzy logic and Neural Network" de Bart Kosko....Ils sont revenus à la mode grace au big data et aux GPU ....

"Les méthodes d'IA plus classiques que tu évoques ont des propriétés et posent des hypothèses différentes." j'ai pas compris

Y'a une amélioration de performance mais pas toujours... Parfois des méthodes de scoring type DEA ou Prométhée sont largement assez efficace quand on fait du scoring. Un de mes principes est d'ailleurs de combiner des méthodes mathématiques déterministes avec de l'IA connectiviste....

Je serais curieux de lire la publi de Stanford si tu la retrouves.

Il y a clairement un emballement autour de l'IA qui rend confus ce qui est vraiment derrière (voir l'épisode zéro du périodique de MadeByHumans : https://madebyhumans...ory/periodique/ ).

).

Le terme d'Intelligence Artificielle en soi est trompeur : il désigne des méthodes et algos de décision automatique, d'inférence, bref, des modèles de ce qu'on comprend comme étant des marqueurs de l'intelligence humaine. En pratique, aucune de ces méthodes prise individuellement n'est de l'intelligence : une prise de décision n'est rien sans capacité d'inférence, elle-même ayant besoin de modèles de connaissances que le machine learning fourni.

Un terme plus juste pour toutes ces techniques (NN, algo génétiques, inférence bayésienne, logique floue) sont du "traitement automatique de l'information/la connaissance". Mais c'est moins vendeur que "Intelligence artificielle"

"Les méthodes d'IA plus classiques que tu évoques ont des propriétés et posent des hypothèses différentes." j'ai pas compris

Exemple : les réseaux de neurones sont des approximateurs de fonction linéaire ou non-linéaire. Les hypothèses sont qu'on dispose de données sur lesquels les entraîner, que ces données sont indépendantes. Ils permettent de faire de la prédiction continue (régression), catégorique (classificateur), mais n'adressent pas la problématique de l'exploration de l'espace du problème.

Les algos génétiques sont des méthodes d'exploration de l'espace des solutions selon un critère d'optimalité (sélection et reproduction des meilleurs individus) et maintien d'une certaine diversité (mutation).

Comme dans tous les domaines, il y a des méthodes établies qui marchent très bien (pourquoi utiliser un réseau de neurones si on est capable de calculer analytiquement la solution exacte ?) et des problèmes plus complexes pour lesquelles on dispose de moins d'information et pour lesquelles des méthodes de ML (pas que NN) se justifient (au prix des preuves formelles de fonctionnement que l'industrie requiert d'un produit). Faire du Deep NN à toutes les sauces sans se poser la question du problème qu'on veut adresser, ça peut marcher (hélas) mais ça n'est pas une démarche formelle et rigoureuse.

(va peut-être falloir continuer la discussion dans un autre fil  )

)