- ashira aime ceci

Homme

Homme

Posté par R1D1

- 19 novembre 2019 - 12:01

Posté par R1D1

- 19 novembre 2019 - 12:01

Posté par R1D1

- 30 octobre 2019 - 11:03

Posté par R1D1

- 30 octobre 2019 - 11:03

Posté par R1D1

- 30 octobre 2019 - 10:11

Posté par R1D1

- 30 octobre 2019 - 10:11

Posté par R1D1

- 29 octobre 2019 - 09:59

Posté par R1D1

- 29 octobre 2019 - 09:59

Posté par R1D1

- 21 octobre 2019 - 09:34

Posté par R1D1

- 21 octobre 2019 - 09:34

Posté par R1D1

- 24 septembre 2019 - 03:35

Posté par R1D1

- 24 septembre 2019 - 03:35

Posté par R1D1

- 20 septembre 2019 - 03:18

Posté par R1D1

- 20 septembre 2019 - 03:18

et pourquoi pas 4 entrées avec du cyan magenta jaune et noir comme sur les imprimantes papier pour pouvoir recréer toutes les couleurs ?

Posté par R1D1

- 07 septembre 2019 - 09:49

Posté par R1D1

- 07 septembre 2019 - 09:49

Posté par R1D1

- 28 juillet 2019 - 10:00

Posté par R1D1

- 28 juillet 2019 - 10:00

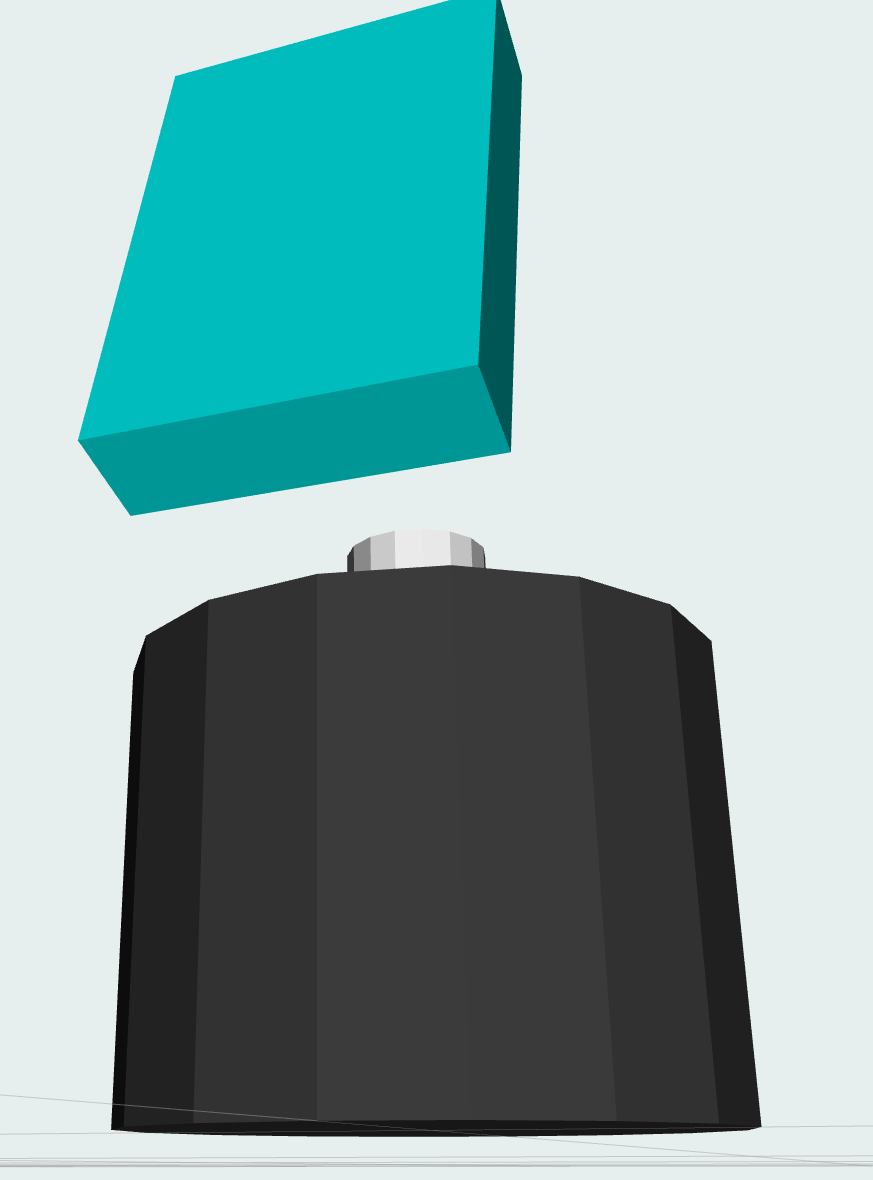

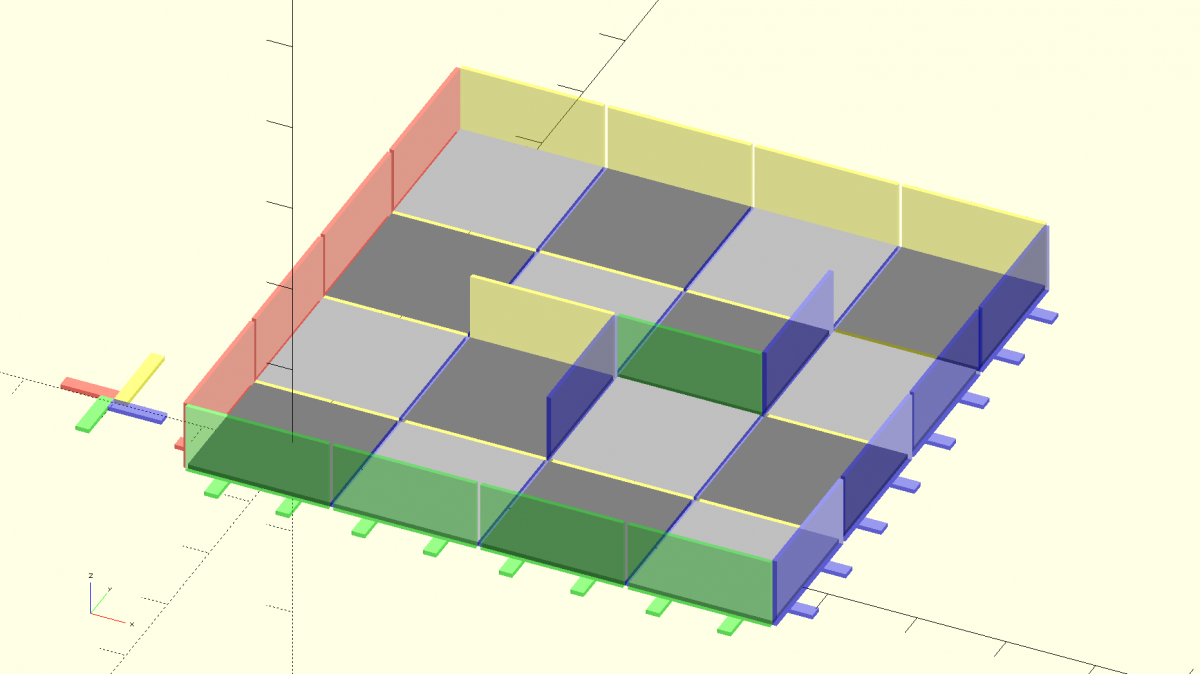

Bonsoir !

Comme je l'avais évoqué dans le sujet de pmdd (voir ici: https://www.robot-ma...o-ev3/?p=104534), j'ai besoin d'un labyrinthe modulaire pour mes stagiaires. Après un design rapide sous Openscad pour avoir une idée de la réalisation, j'ai coupé une planche qui traînait pour faire mes parties. À la main, parce que ma scie sauteuse ne coupe pas droit !

Puis ponçage des pièces et assemblage des murs avec un clou et de la colle à bois ... Beaucoup d'huile de coude dans le processus.

Les murs font 80x160 mm, les plaques 160x160mm

Le labyrinthe est modulaire, on peut changer sa configuration case par case. Il me manque juste à faire quelques pieds supplémentaires pour que toutes les planchers soient bien à plat.

Posté par R1D1

- 26 juillet 2019 - 12:24

Posté par R1D1

- 26 juillet 2019 - 12:24

maze_plates.scad.zip 765 octets

150 téléchargement(s)

maze_plates.scad.zip 765 octets

150 téléchargement(s)

Posté par R1D1

- 12 juillet 2019 - 08:45

Posté par R1D1

- 12 juillet 2019 - 08:45

Posté par R1D1

- 04 juillet 2019 - 11:07

Posté par R1D1

- 04 juillet 2019 - 11:07

Posté par R1D1

- 17 juin 2019 - 10:12

Posté par R1D1

- 17 juin 2019 - 10:12

Yop !

Fin Mai, j'ai eu l'occasion d'aller à ICRA, une des deux plus grosses conférences de robotique à Montréal, du coup, voici quelques photos et vidéos de ce que j'ai pu y voir:

- Palais des Congrès de Montréal:

- Robot Fetch

- DJI et son Challenge RoboMaster

- Laikago et Spot Mini nous ont fait de belles démos:

- Robotique modulaire (Hebi robotics)

- Clearpath Warthog, robot d'extérieur:

- Robotique et art :

Mon contenu

Mon contenu